Etika AI: Panduan Hadapi Dilema Moral Mesin Cerdas

Tahukah Anda bahwa mayoritas data yang digunakan untuk melatih sistem kecerdasan buatan saat ini tidak mencerminkan keberagaman populasi global? Ini berarti potensi bias dalam AI yang mendalam, mempengaruhi segala hal mulai dari aplikasi pinjaman hingga sistem peradilan pidana. Mari kita selami lebih dalam tentang bagaimana kita bisa mengatasi tantangan ini.

Memahami Esensi Moralitas AI

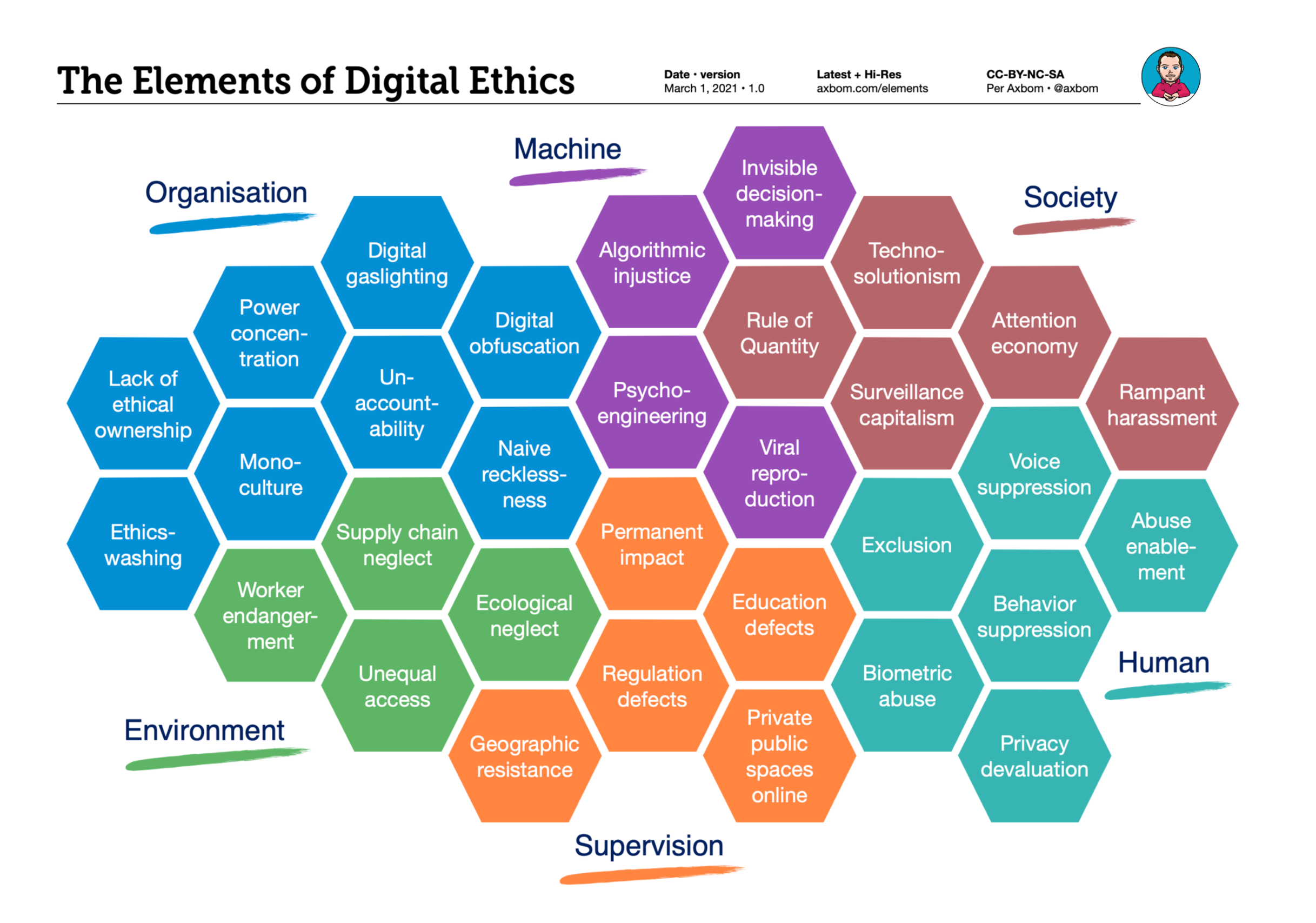

Moralitas AI bukan sekadar kata kunci; ini adalah fondasi yang harus mendasari setiap aspek pengembangan dan penerapan kecerdasan buatan. Kita berbicara tentang menanamkan prinsip-prinsip etika ke dalam algoritma dan sistem AI sehingga mereka dapat membuat keputusan yang selaras dengan nilai-nilai kemanusiaan. Ini mencakup keadilan, transparansi, akuntabilitas, dan non-diskriminasi. Bayangkan sebuah dunia di mana AI tidak hanya cerdas, tetapi juga adil, bertanggung jawab, dan berempati. Itu adalah tujuan yang kita perjuangkan dengan etika AI.

Namun, mewujudkan visi ini tidaklah mudah. Dilema etika AI muncul di setiap sudut. Pertimbangkan kasus mobil otonom yang harus memilih antara menabrak pejalan kaki atau pengemudi. Siapa yang harus diprioritaskan? Atau sistem AI yang digunakan dalam perekrutan yang secara tidak sengaja mendiskriminasi kandidat berdasarkan jenis kelamin atau ras. Bagaimana kita memastikan bahwa algoritma yang adil digunakan untuk menghindari hasil yang merugikan?

Mengatasi kompleksitas ini membutuhkan pendekatan multidisiplin, yang melibatkan para ahli etika, ilmuwan komputer, pembuat kebijakan, dan masyarakat umum. Kita harus mengembangkan kerangka kerja etika yang komprehensif yang dapat memandu pengembangan dan penerapan kecerdasan buatan yang bertanggung jawab.

Keadilan dalam Algoritma

Salah satu tantangan utama dalam moralitas AI adalah memastikan keadilan dalam algoritma. Ini berarti menghilangkan bias dalam AI yang dapat menyebabkan hasil diskriminatif. Bias dapat masuk ke dalam sistem AI melalui berbagai cara, termasuk data pelatihan yang bias, desain algoritma yang bias, dan interpretasi hasil yang bias.

Transparansi dan Akuntabilitas

Selain keadilan, transparansi dan akuntabilitas juga penting. Kita perlu memahami bagaimana sistem AI membuat keputusan dan siapa yang bertanggung jawab ketika terjadi kesalahan. Ini membutuhkan pengembangan teknik AI yang dapat dijelaskan dan mekanisme akuntabilitas yang jelas.

Menavigasi Dilema Etika AI: Studi Kasus

Untuk memahami tantangan etika AI dengan lebih baik, mari kita bahas beberapa studi kasus:

| Studi Kasus | Isu Etika | Potensi Dampak |

|---|---|---|

| Mobil Otonom | Dilema moral dalam situasi kecelakaan | Keputusan hidup dan mati, tanggung jawab hukum |

| Sistem Perekrutan AI | Diskriminasi berdasarkan jenis kelamin atau ras | Ketidakadilan dalam kesempatan kerja |

| Pengenalan Wajah | Pelanggaran privasi, kesalahan identifikasi | Pengawasan massal, penangkapan yang salah |

Studi kasus ini menyoroti pentingnya mempertimbangkan implikasi etika dari sistem AI sejak awal pengembangan. Kita perlu mengidentifikasi potensi risiko dan mengembangkan strategi mitigasi untuk meminimalkan dampak negatif.

Solusinya tidak selalu mudah. Seringkali, ada trade-off antara berbagai nilai etika. Misalnya, meningkatkan akurasi sistem pengenalan wajah dapat mengorbankan privasi individu. Kita perlu menimbang manfaat dan risiko secara hati-hati dan membuat keputusan yang bertanggung jawab.

Tanggung Jawab AI: Siapa yang Bertanggung Jawab?

Salah satu pertanyaan paling mendasar dalam etika AI adalah: siapa yang bertanggung jawab atas tindakan sistem AI? Apakah itu pengembang, produsen, atau pengguna? Jawabannya tidak selalu jelas. Tanggung jawab AI adalah konsep kompleks yang melibatkan berbagai aktor dan pertimbangan.

Jika sistem AI menyebabkan kerugian, siapa yang harus dimintai pertanggungjawaban? Apakah itu pengembang yang merancang algoritma, perusahaan yang menerapkan sistem, atau individu yang menggunakan sistem? Jawabannya tergantung pada sejumlah faktor, termasuk sifat kerugian, tingkat kontrol atas sistem, dan standar hukum yang berlaku.

Untuk mengatasi tantangan ini, kita perlu mengembangkan kerangka kerja hukum dan etika yang jelas untuk tanggung jawab AI. Ini harus mencakup mekanisme untuk menetapkan tanggung jawab, memberikan kompensasi kepada korban, dan mencegah kejadian serupa di masa depan.

Akuntabilitas dalam Pengembangan AI

Akuntabilitas dalam pengembangan AI adalah proses menetapkan tanggung jawab dan kewajiban kepada individu atau organisasi yang terlibat dalam perancangan, pengembangan, dan penerapan sistem AI. Hal ini mencakup tanggung jawab untuk memastikan bahwa sistem AI aman, adil, dan etis.

Membangun Sistem AI yang Dapat Dipercaya

Membangun sistem AI yang dapat dipercaya adalah proses merancang dan mengembangkan sistem AI yang aman, andal, dan dapat diandalkan. Ini membutuhkan pendekatan multidisiplin yang menggabungkan teknik dari ilmu komputer, etika, hukum, dan bidang lainnya.

Regulasi AI: Perlukah Intervensi Pemerintah?

Perdebatan tentang regulasi AI semakin intensif. Beberapa orang berpendapat bahwa regulasi diperlukan untuk melindungi masyarakat dari potensi risiko kecerdasan buatan. Yang lain khawatir bahwa regulasi dapat menghambat inovasi dan kemajuan teknologi. Lalu, bagaimana seharusnya pemerintah mengatur kecerdasan buatan?

Ada berbagai pendekatan untuk regulasi AI. Beberapa negara telah mengadopsi pendekatan yang sangat hati-hati, memberlakukan pembatasan ketat pada pengembangan dan penerapan sistem AI. Negara lain telah mengambil pendekatan yang lebih fleksibel, berfokus pada pengembangan standar etika dan praktik terbaik.

Penting untuk menemukan keseimbangan yang tepat antara mendorong inovasi dan melindungi masyarakat. Regulasi AI harus dirancang untuk mengatasi risiko yang paling signifikan sambil meminimalkan beban pada industri AI.

Regulasi dapat mencakup berbagai hal, seperti:

- Standar untuk keamanan dan keandalan sistem AI

- Persyaratan untuk transparansi dan akuntabilitas

- Pembatasan pada penggunaan AI dalam aplikasi tertentu

- Mekanisme untuk menegakkan regulasi

| Pendekatan Regulasi | Kelebihan | Kekurangan |

|---|---|---|

| Regulasi Ketat | Perlindungan yang kuat terhadap risiko AI | Dapat menghambat inovasi |

| Regulasi Fleksibel | Mendorong inovasi | Perlindungan yang lebih lemah terhadap risiko AI |

| Standar Etika | Mempromosikan pengembangan AI yang bertanggung jawab | Tidak mengikat secara hukum |

Penting untuk dicatat bahwa regulasi AI masih dalam tahap awal. Banyak negara masih bergulat dengan cara terbaik untuk mengatur teknologi ini. Seiring dengan perkembangan kecerdasan buatan, kerangka kerja regulasi juga harus berkembang.

Dampak Sosial AI: Lebih dari Sekadar Teknologi

Dampak sosial AI jauh melampaui efisiensi dan otomatisasi. Kecerdasan buatan berpotensi mengubah cara kita bekerja, berinteraksi, dan hidup. Ini dapat meningkatkan produktivitas, meningkatkan perawatan kesehatan, dan memecahkan masalah kompleks. Namun, hal itu juga menimbulkan tantangan signifikan, seperti hilangnya pekerjaan, ketidaksetaraan, dan erosi privasi.

Kita perlu mempertimbangkan dampak sosial AI secara holistik dan mengembangkan strategi untuk memaksimalkan manfaat dan meminimalkan risiko. Ini membutuhkan keterlibatan aktif dari semua pemangku kepentingan, termasuk pemerintah, industri, akademisi, dan masyarakat sipil.

Peran Pendidikan dan Kesadaran Publik

Pendidikan dan kesadaran publik memainkan peran penting dalam membentuk dampak sosial AI. Kita perlu mendidik masyarakat tentang potensi manfaat dan risiko AI, serta bagaimana mereka dapat berpartisipasi dalam pengambilan keputusan tentang pengembangan dan penerapan AI.

Menanamkan Nilai-nilai Etika dalam AI: Langkah Konkret

Bagaimana kita benar-benar menanamkan nilai-nilai etika dalam AI? Ini membutuhkan pendekatan berlapis, mulai dari pendidikan hingga desain algoritma, dan dari kebijakan perusahaan hingga regulasi AI.

- Pendidikan dan Pelatihan: Menanamkan etika ke dalam kurikulum ilmu komputer dan melatih para pengembang untuk mempertimbangkan implikasi etika dari pekerjaan mereka.

- Desain Algoritma yang Etis: Mengembangkan algoritma yang adil, transparan, dan akuntabel.

- Kebijakan Perusahaan yang Bertanggung Jawab: Membuat kebijakan yang mempromosikan pengembangan AI yang bertanggung jawab dan melindungi hak-hak individu.

- Regulasi Pemerintah yang Tepat: Menerapkan regulasi yang mengatasi risiko signifikan AI sambil mendorong inovasi.

- Keterlibatan Publik: Melibatkan masyarakat umum dalam diskusi tentang etika AI dan memastikan bahwa suara mereka didengar.

"Masa depan kecerdasan buatan bukan hanya tentang menciptakan mesin yang cerdas, tetapi tentang menciptakan mesin yang baik." - Prof. Dr. Jane Doe, Ahli Etika AI Terkemuka.

FAQ (Frequently Asked Questions)

Berikut adalah beberapa pertanyaan yang sering diajukan tentang etika AI:

- Apa itu etika AI? Etika AI adalah cabang etika terapan yang berfokus pada implikasi moral dari kecerdasan buatan.

- Mengapa etika AI penting? Etika AI penting untuk memastikan bahwa kecerdasan buatan digunakan untuk kebaikan dan bahwa risiko yang terkait dengan teknologi ini diminimalkan.

- Siapa yang bertanggung jawab atas etika AI? Semua pemangku kepentingan, termasuk pengembang, produsen, pemerintah, dan masyarakat umum, bertanggung jawab atas etika AI.

- Bagaimana kita dapat memastikan bahwa kecerdasan buatan digunakan secara etis? Kita dapat memastikan bahwa kecerdasan buatan digunakan secara etis dengan mengembangkan kerangka kerja etika yang komprehensif, menerapkan regulasi yang tepat, dan meningkatkan kesadaran publik.